9月22日上午,第十四期 DISCOVER LAB 青年科学家论坛顺利开展。本期活动有幸邀请到达特茅斯做愛姿势

助理教授杨耀青博士,为我们线上做了题为 Quantifying generalization of neural networks by measuring loss landscapes and weight matrices(通过损失函数形态和权矩阵定量衡量神经网络泛化性)的精彩报告。

杨耀青博士即将加入达特茅斯做愛姿势

计算机系成为助理教授,他现在是加州大学伯克利分校RISE Lab的博士后研究员。他本科毕业于做愛姿势

,博士毕业于卡耐基梅隆大学。在博士期间,他在诸如NeurIPS,CVPR,IEEE Transactions on Information Theory 等知名期刊和会议上发表过多篇文章,并且曾在微软,贝尔实验室等多个知名机构工作和实习。现在,他专注于机器学习领域,在这个领域的主要贡献是在机器学习算法和系统存在不确定性的情况中提升可靠性和泛化性能。

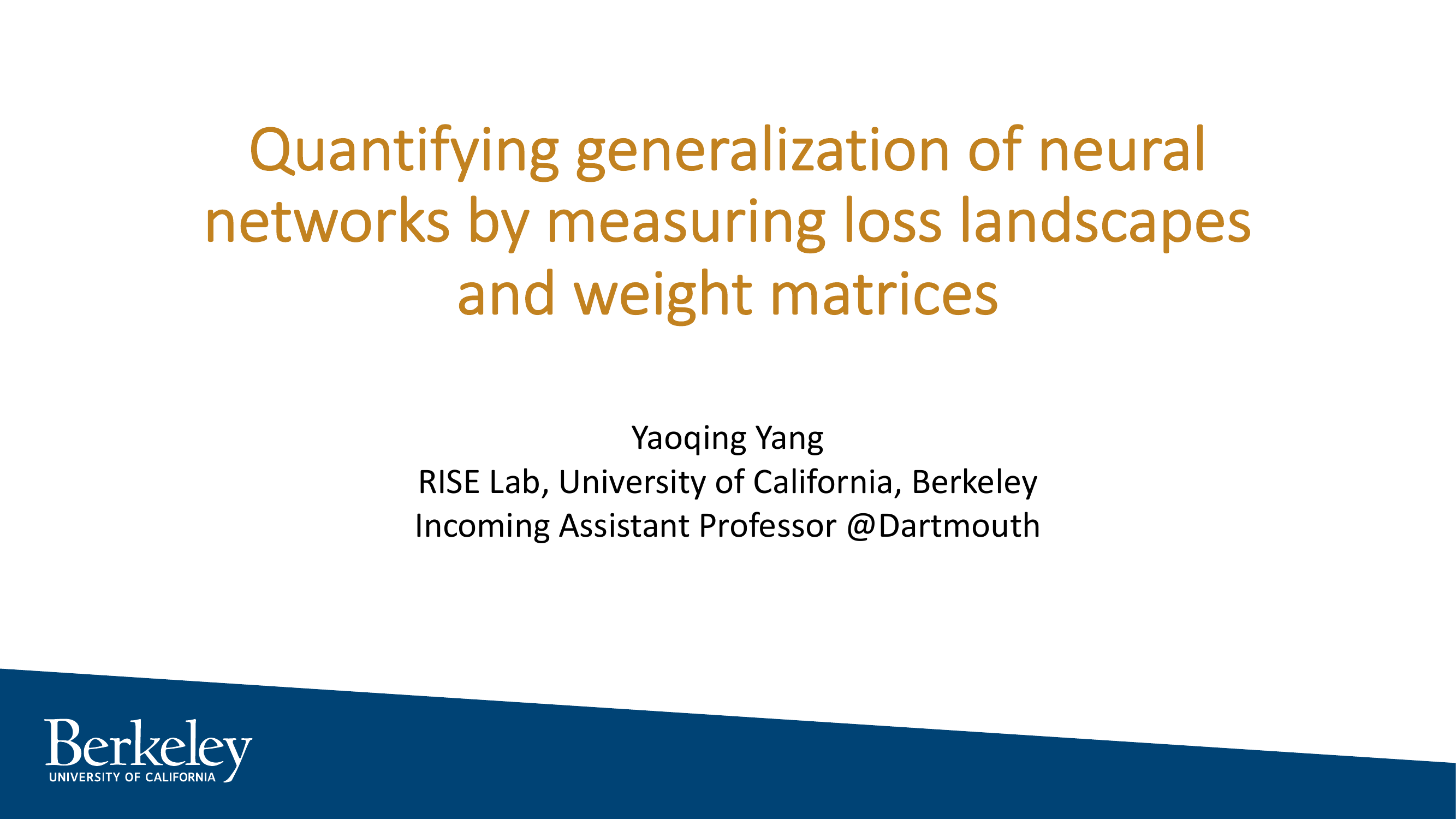

本次报告中,杨耀青博士介绍了他和团队在神经网络泛化性,神经网络权重测量,以及网络优化损失函数图景方面的最新进展。

本次报告主要分为两部分。在第一部分,杨耀青博士主要介绍了”相图”的概念,讨论了如何通过损失函数的全局形态来预测机器学习模型问题并提高泛化性能;在第二部分,则主要介绍了如何在不接触训练与测试数据的情形下,直接从模型参数中预测预训练模型(如Huggingface Transformers)的泛化表现。在报告的最后,杨博士与同学们就报告中的内容展开了热烈的讨论。

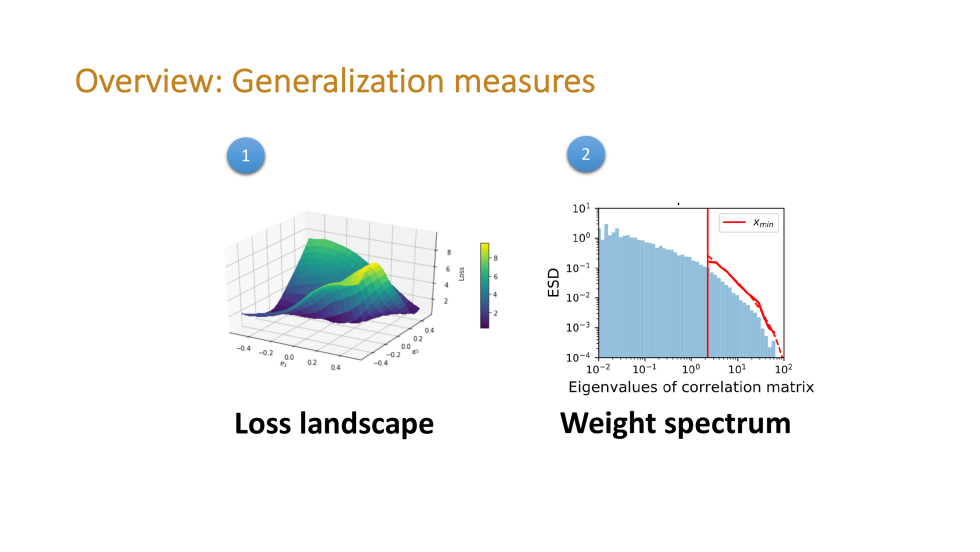

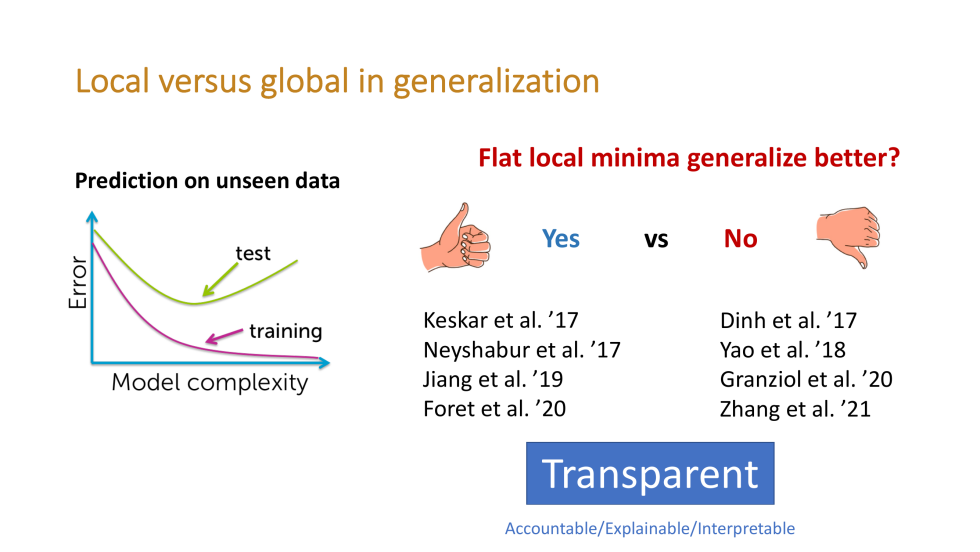

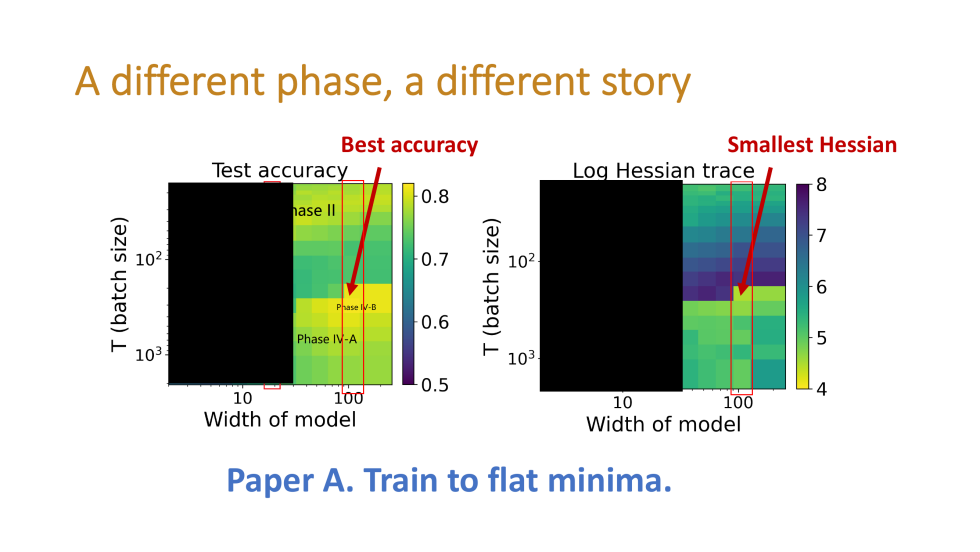

杨耀青博士首先介绍了泛化性研究的背景。神经网络在测试数据上的泛化性是机器学习技术得以应用的基础。研究神经网路泛化性的一种常用方法是衡量损失函数(loss)的局部形态(local landscape)。许多过去的研究认为模型收敛于平坦的局部极小(flat local minima)可以达到更好的泛化效果。然而,也有许多研究认为这收敛位置的 flat or sharp 并不是取得好的泛化效果的关键。

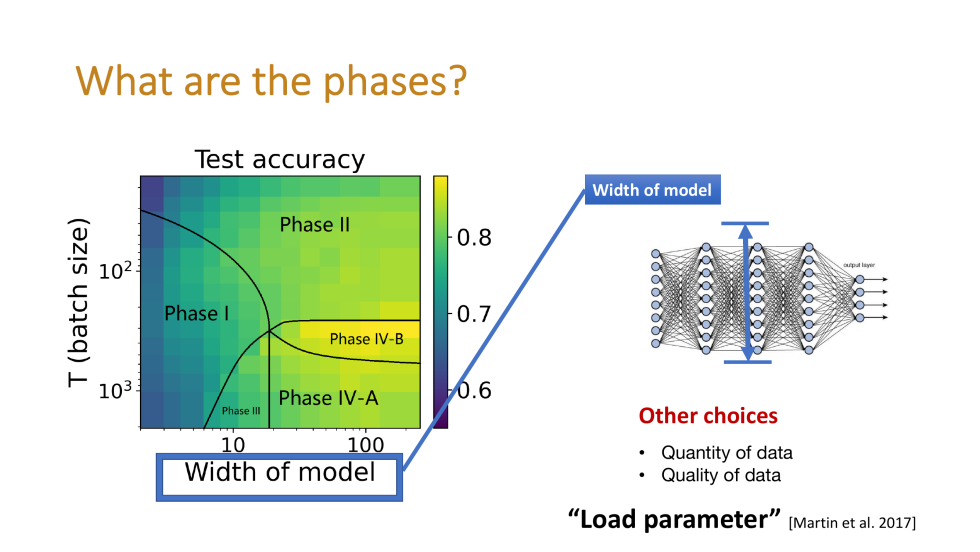

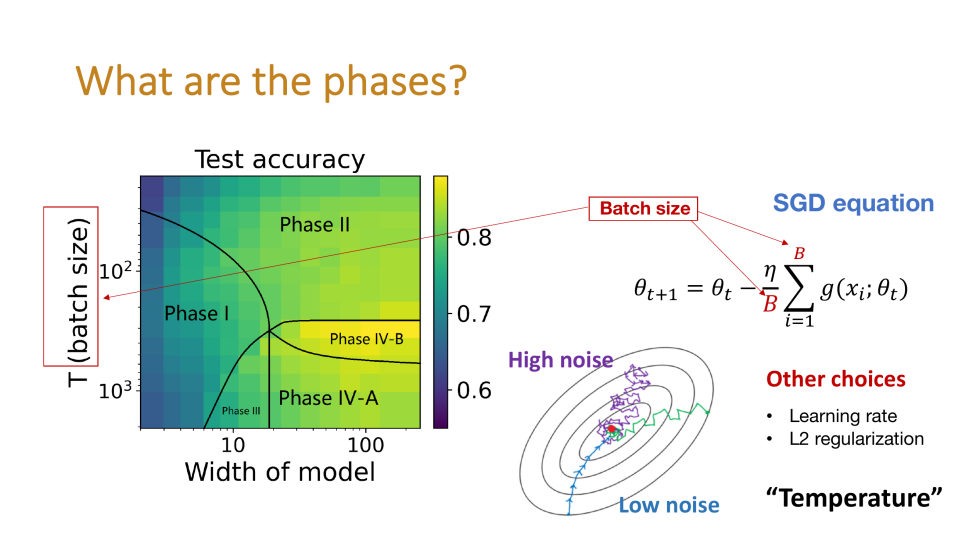

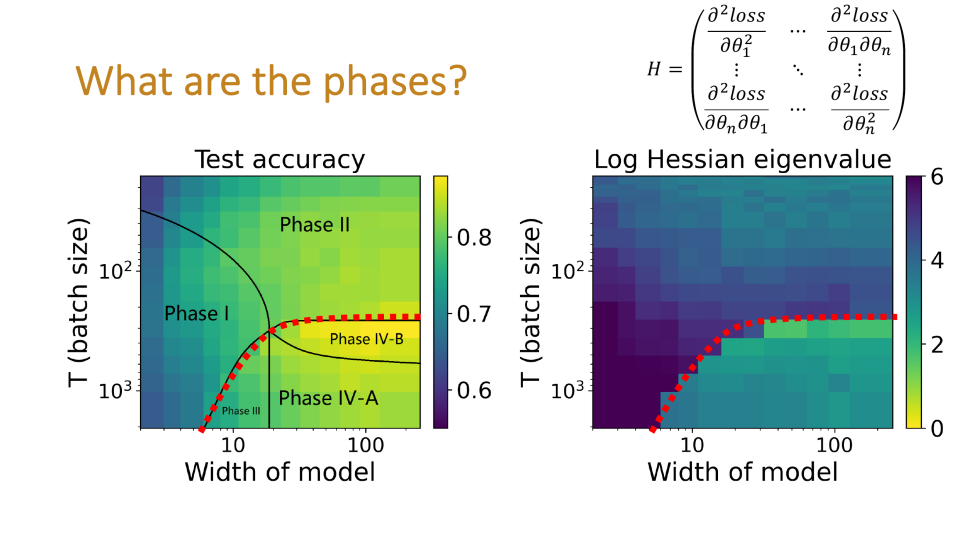

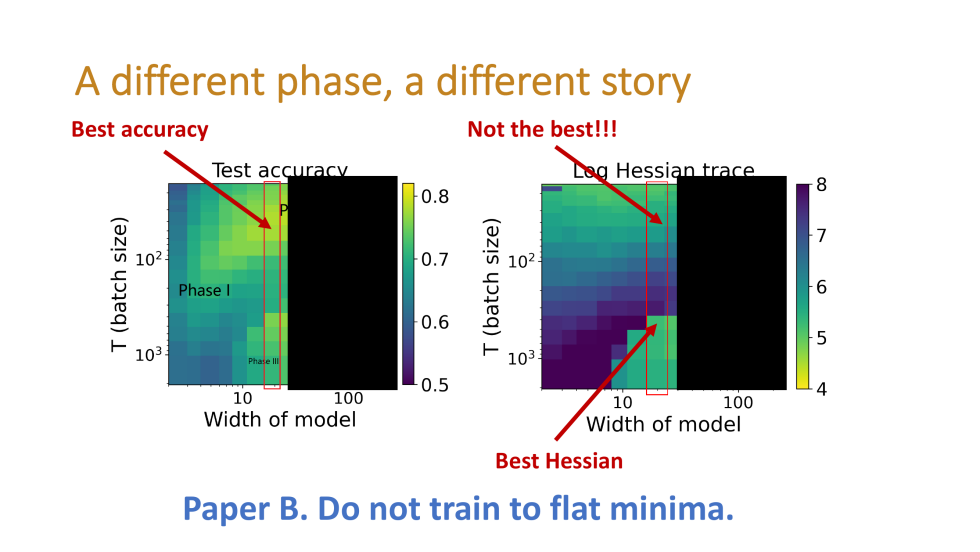

杨耀青博士及其团队在 NeurIPS2021 的一篇工作“Taxonomizing local versus global structure in neural network loss landscapes”中指出,损失函数形态与模型泛化性之间呈现的关系与模型训练超参所处的 ”相” (Phase)有关,而“相”对应的模型性能则可以通过 ”相图” 来刻画。相图的横轴对应于模型的 ”尺寸”,可以是隐藏层的大小、训练数据的数量或质量等;而纵轴则对应于训练的”温度”,表示模型在训练过程中的噪声程度,可以是 batch 的大小、学习率等。而图中的色温则代表模型的性能,如准确率。这种关于相图的研究在机器学习的统计物理方法(statistical mechanics of machine learning)中有着广泛应用。

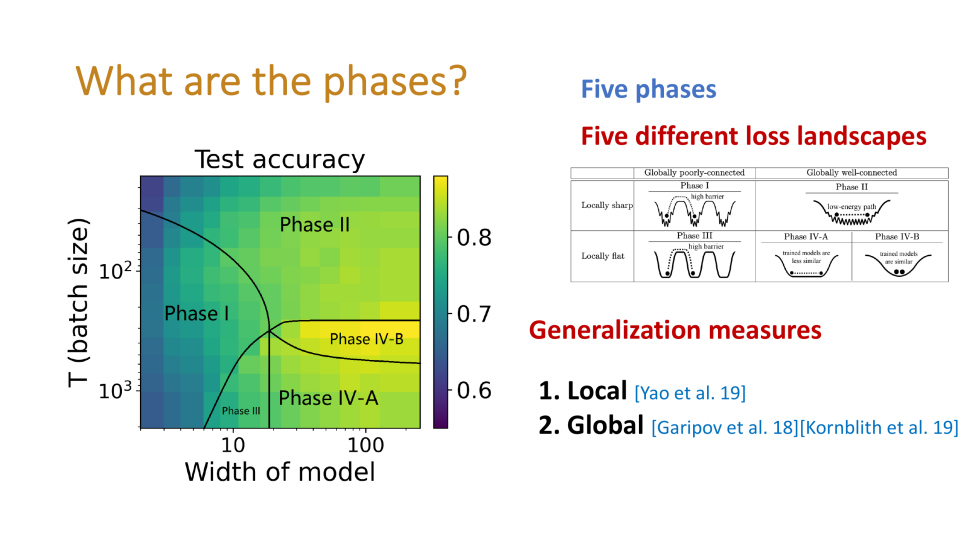

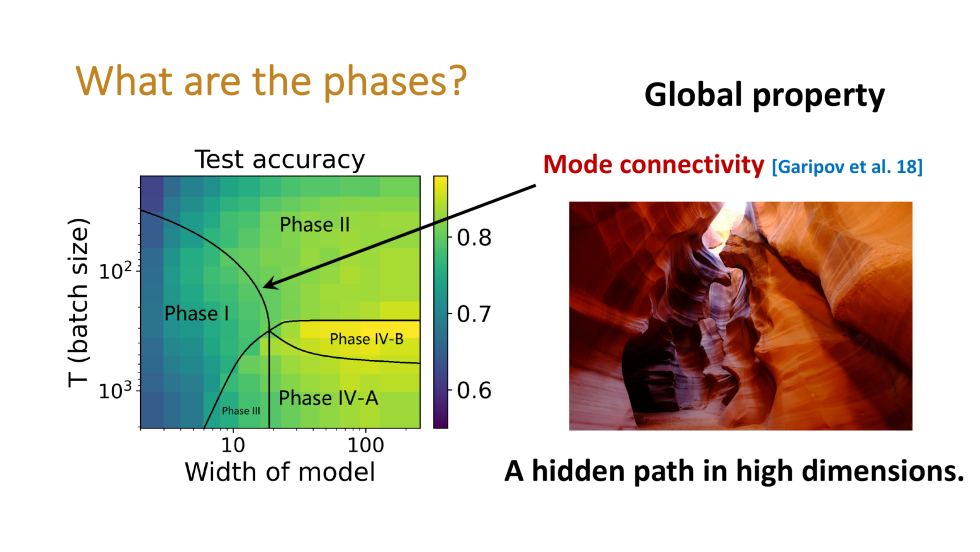

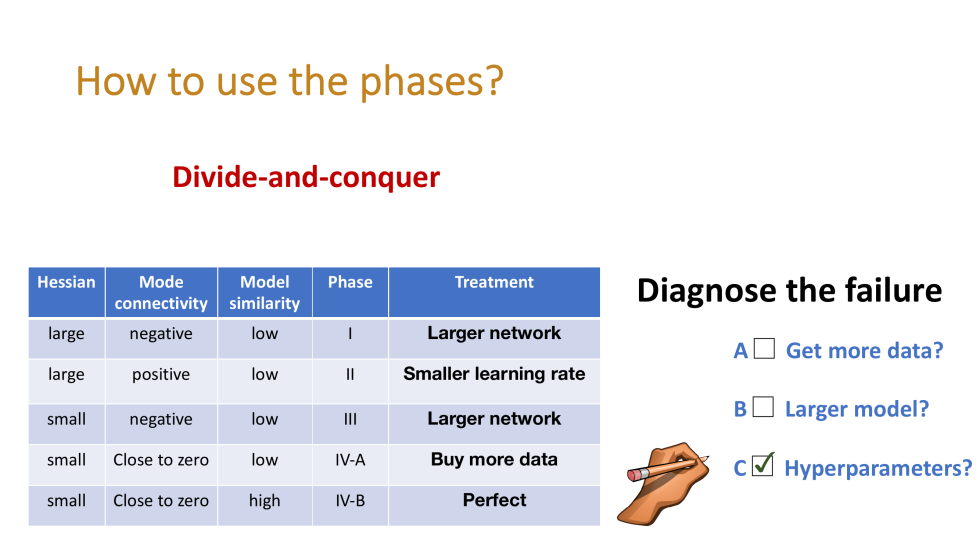

“相“可以由两种依据进行划分。(一)极小值的局部形态(local landscape),也就是在收敛点附则极小值随扰动的变化率,可以使用损失函数 Hessian 矩阵的特征值进行定量刻画。特征值高或者Hessian的迹(Trace)大则表示变化较为剧烈。(二)极小值之间的全局特征,可以使用模式之间的连通性(mode connectivity)来衡量。直观来说,也就是收敛点到其附近的其他极小值的路径上是否会存在较大的 loss。由此,我们可以从损失函数的局部和全局形态两个角度,将训练的超参数划分为 4 个相。而对于较为理想的 Phase-IV,其又可以进一步按照模型之间的距离远近分为 IV-A 和 IV-B。研究发现,收敛点附近损失函数平坦,模型连通性良好且距离较近的相位(IV-B),容易表现出更加优良的泛化性。

“相“可以由两种依据进行划分。(一)极小值的局部形态(local landscape),也就是在收敛点附则极小值随扰动的变化率,可以使用损失函数 Hessian 矩阵的特征值进行定量刻画。特征值高或者Hessian的迹(Trace)大则表示变化较为剧烈。(二)极小值之间的全局特征,可以使用模式之间的连通性(mode connectivity)来衡量。直观来说,也就是收敛点到其附近的其他极小值的路径上是否会存在较大的 loss。由此,我们可以从损失函数的局部和全局形态两个角度,将训练的超参数划分为 4 个相。而对于较为理想的 Phase-IV,其又可以进一步按照模型之间的距离远近分为 IV-A 和 IV-B。研究发现,收敛点附近损失函数平坦,模型连通性良好且距离较近的相位(IV-B),容易表现出更加优良的泛化性。

相图可以用于解释许多机器学习中与泛化有关的现象。首先,关于报告开头提到的损失函数局部形态与泛化性的关系,通过相图可以发现,模型”尺寸”较小时,泛化性最好的位置并不是局部最为平坦的位置;而模型尺寸较大时,则会在局部平坦的位置取得较好的泛化性。更重要的是,相图可以直观地查找模型训练过程中的问题,用来得到比较合适的调参方向(比如,增大数据集,或者改变模型,还是进一步调整参数大小)。

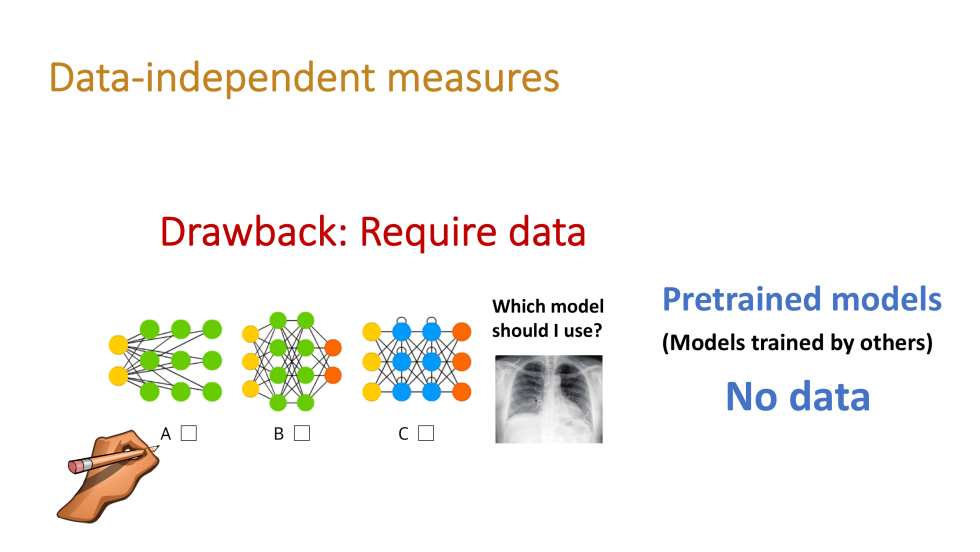

报告的第二部分,杨耀青博士介绍了在缺乏数据集的情况下衡量模型质量的定量指标。深度学习研究中广泛使用了预训练模型(pretrained models,比如各种Huggingface Transformers),而我们很难获得其在训练时使用的数据,这就要求我们在做模型选择(model selection)时,独立于训练数据的方法来衡量模型的质量。

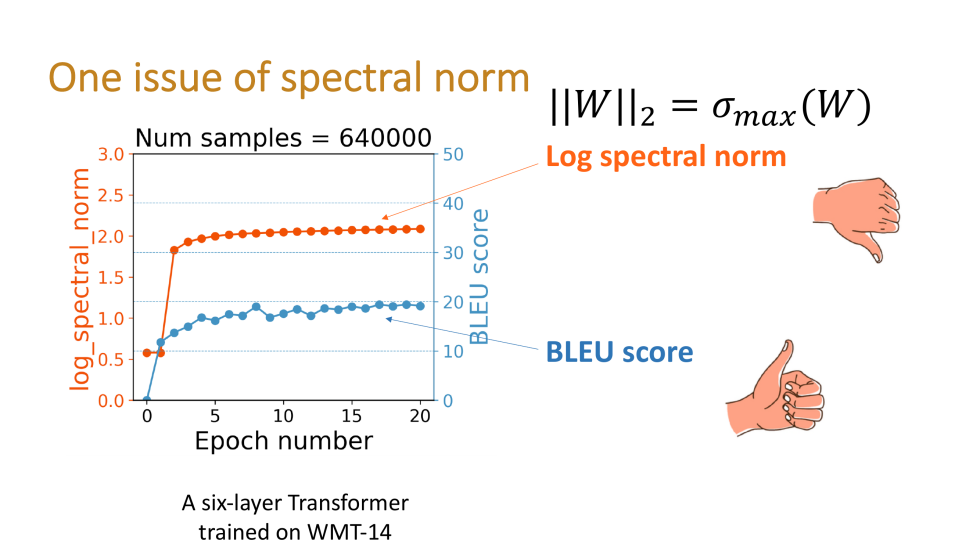

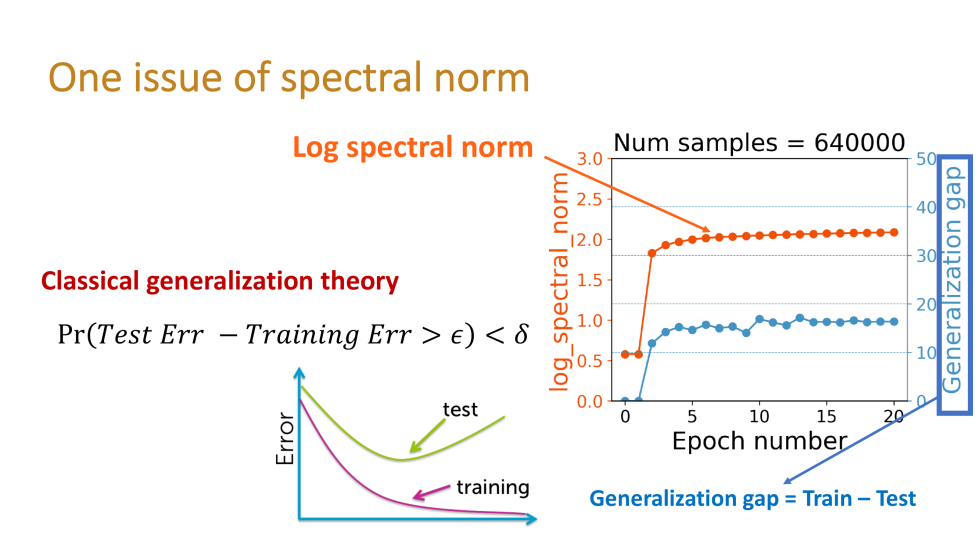

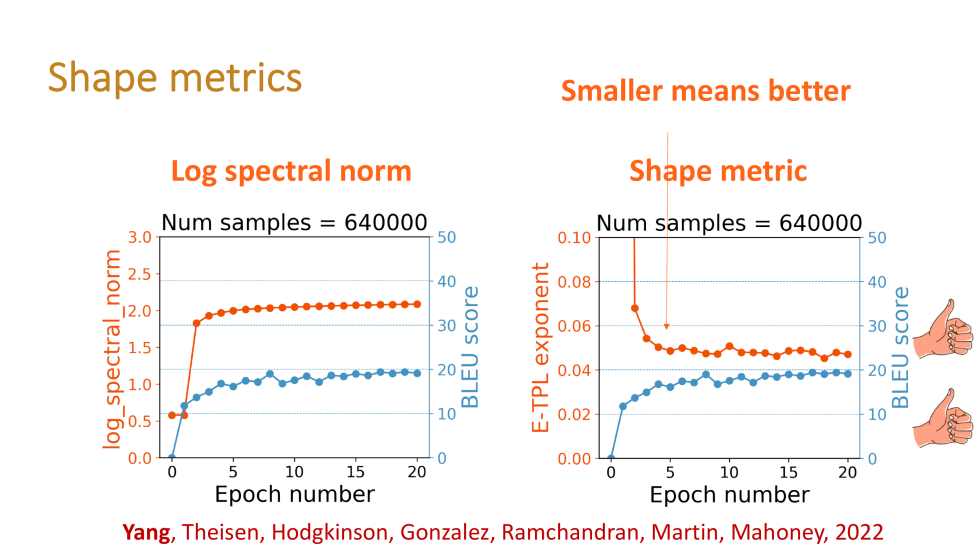

一种从模型参数直接衡量模型质量的指标是取用模型权矩阵的最大奇异值(谱范数)。然而,这一方法有时会得出反直觉的结论。例如在一个 6 层 Transformer 模型的训练过程中,对数谱范数随 BLEU 分数一致提高,似乎可以反应模型的质量;然而,从最大奇异值同时在一定程度上反映了模型的复杂程度,而根据奥卡姆剃刀原则,复杂程度较高的模型泛化较好则是不太合理的。

进一步的研究发现,谱范数事实上反映了模型的泛化差异(Generalization Gap),即训练过程中,模型在训练集和测试集上测试指标的差异。泛化差异随着模型的训练增加则符合机器学习过程中的普遍经验。

然而,模型的质量通常使用在测试集上的表现,而不是使用在训练集与测试集上的差异来进行评估。而”形状指标” (Shape Metrics)则能更好地反应模型在测试集上的表现,而不是泛化差异。在这一方面,杨耀青博士及其团队提出了通过拟合经验谱密度来衡量模型质量的方法。从图中可以发现,形状指标能更好地反应模型在测试集上的表现,也就是模型的泛化性能,同时还具有可以从参数中直接测量而无需其他数据的优势。

对指标与性能的相关性分析表明,许多曾经用于预测模型性能的指标(图中砖红色),事实上是对泛化差异的反映,而形状指标则能更好地预测模型的质量。

在报告的最后,杨耀青博士与同学们就报告中所涉及的内容进行了热烈的讨论,并就同学们提出的问题,如泛化性指标的实现细节,泛化性度量指标在优化算法中的应用,半监督学习与模型相似性之间的关系,机器学习中的”相”与统计物理中相关概念的联系等等进行了详细的解答。

文稿撰写 / 刘明道

排版编辑 / 蒲睿熙

校对责编 / 黄 妍